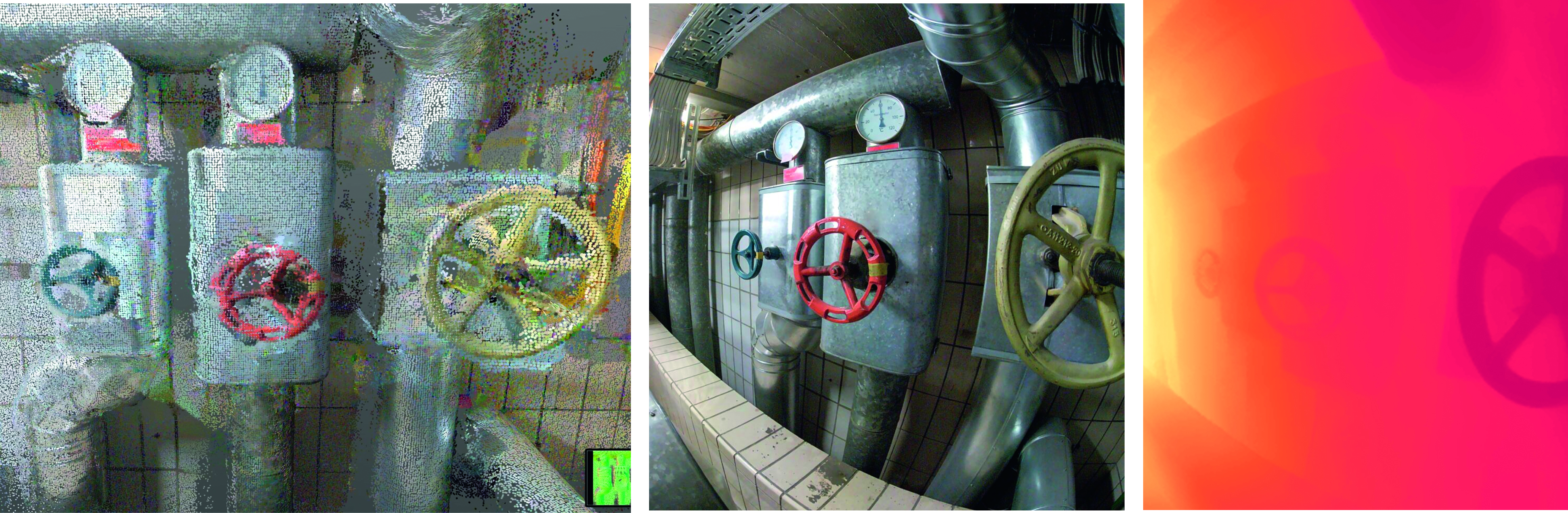

Mit 3D-Laserscannern können Gebäude von innen und außen sehr präzise vermessen werden. Die Auflösung reicht jedoch nicht an das heran, was man von Fotografien gewohnt ist. Ziel des Projekts ist es, die Algorithmik und ein Aufnahmesystem zu entwickeln, mit denen man den hohen Detailgrad von Fotografien auf 3D-Laserscans übertragen kann.

Die 3D-Erfassung unserer Umgebung ist ein seit langem erforschtes Gebiet, auf dem es in den vergangenen Jahren enorme Fortschritte in der Sensorik und der Algorithmik gab. 3D-Laserscanner können ihre Umwelt mit hoher Genauigkeit und einer Auflösung im Zentimeter- oder Millimeterbereich erfassen. Gleichzeitig ist eine „Demokratisierung“ der 3D-Rekonstruktion zu beobachten, gestützt durch weit verfügbare Sensorik auf vielen Handys. Dennoch reichen Auflösung und Qualität der erzielbaren 3D-Modelle nicht an das heran, was man von Fotografien gewohnt ist. Neueste neuronale Verfahren können 3D-Werte direkt aus Fotografien schätzen, die metrische Genauigkeit ist dabei jedoch oft mangelhaft.

Ziel des Projekts ist es, die Lücke zwischen 3D-Laserscans und Fotografien zu schließen, indem 3D-Daten von einem Laserscanner anhand parallel aufgenommener Fotografien verfeinert werden. In diesem Projekt entwickeln wir hybride Rekonstruktionsverfahren, die auf klassischer Optimierung sowie auf Methoden des maschinellen Lernens basieren. Parallel dazu wird eine Reihe technischer und algorithmischer Fragen erforscht. So sind verschiedene Bereiche einer Szene unterschiedlich gut zugänglich und können nur in variierender Auflösung und Qualität aufgenommen werden. Außerdem stellt die schiere Größe und Komplexität vieler Szenen die Algorithmik vieler 3D Rekonstruktionsverfahren vor Probleme. Es werden daher Verfahren entwickelt, die mit stark variierendem Detailgrad auch in großen und komplexen Umgebungen umgehen können. Gleichzeitig sollen sie den Aufnahmeprozess robuster machen, indem kritische Rekonstruktionsbereiche schnell erkannt und gezielt durch Fotografien verbessert werden können.