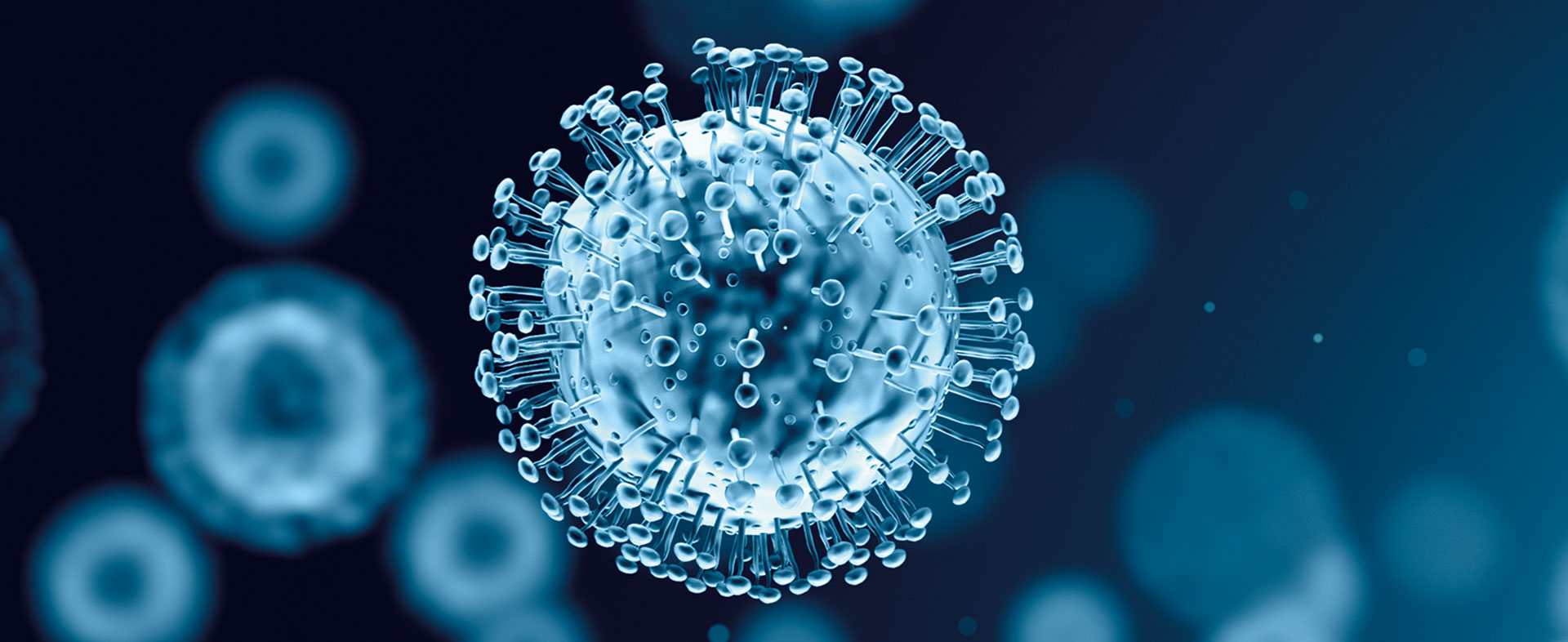

KI-basierten Bildgeneratoren fehlt häufig eine faire und transparente Kontrolle der generierten Inhalte. Im Rahmen des Projekts werden Methoden entwickelt, um Fairness in generativen Modellen messbar zu machen und schon im Trainingsprozess zu optimieren. Dies ermöglicht KI-Systeme, die vielfältig, Bias-frei und zuverlässig arbeiten.

Generative KI-Modelle haben in den vergangenen Jahren große Fortschritte in der Bild- und Textsynthese gemacht. Eine zentrale Herausforderung in diesen Bereichen ist die Bewertung der Diskriminierungsfreiheit bzw. Fairness solcher Systeme. Gesellschaft, Politik und Wirtschaft stellen unterschiedliche Anforderungen, die beachtet werden müssen.

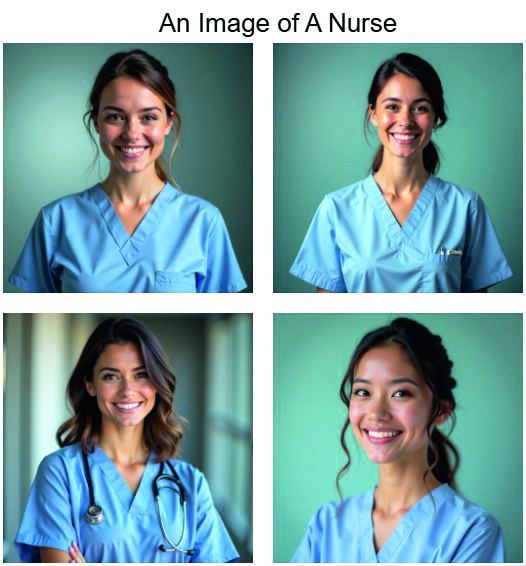

rechts: Bei dem Prompt „An Image of a Nurse“ werden von dem Modell insbesondere weiße Frauen generiert. (Quelle: KI-generierte Bilder, Technische Hochschule Ingolstadt) (Quelle: Wacker Neuson SE)

Ein wichtiger Baustein des Projekts „EvEn FAIr“ ist nicht nur die technische Betrachtung, sondern eine zugrunde liegende ethisch-gesellschaftliche Analyse der Anforderungen von bildgenerierenden KI-Systemen. Anschließend werden diese Erkenntnisse in technische Anforderungen übersetzt, um so einen ganzheitlichen Ansatz der Fairnessbewertung von KI-Systemen zu ermöglichen.

Aufbauend hierauf wird ein technisches Verfahren entwickelt, in dessen Rahmen „klassische“ KI-basierte Modelle verwendet werden, um verschiedene Merkmale wie Geschlecht, Alter oder Herkunft in generierten Bildern zuverlässig zu identifizieren. Aus diesen Merkmalen werden potenzielle Korrelationen abgeleitet, die einen Hinweis auf eine Verzerrung (Bias) geben können. Besonders wichtig ist hierbei die Entwicklung robuster Messgrößen, die auf Basis der zugrunde liegenden ethisch-gesellschaftlichen Studien abgeleitet werden.

Abschließend wird untersucht, wie ein Bias von bildgenerierenden KI-Systemen schon während deren Konzeption und Training vermieden werden bzw. wie die Diskriminierungsfreiheit bereits bestehender Systeme sichergestellt werden kann. Somit verfolgt das Projekt „EvEn FAIr“ einen ganzheitlichen Ansatz von der Identifikation und Feststellung bis hin zur Korrektur potenzieller Verzerrungen. Damit greift das Projekt ein Kernproblem der KI-Forschung auf und eröffnet neue Perspektiven durch die Entwicklung innovativer Fairnessbewertungen.