Das „Hardware/Software-in-the-Loop“-Konzept ist bei der Entwicklung von Systemen in der Automobilindustrie unersetzlich. Eine Simulation aller Komponenten des Fahrzeuges und ein frühzeitiges virtuelles Testen komplexer Algorithmen, wie z. B. Fahrassistenzsysteme oder autonomes Fahren, sind für eine schnelle Entwicklung unabdingbar. Vor allem moderne Sensoren wie Tiefenkameras, Lidar oder Radar sind dabei besonders anspruchsvoll, da sie eine enorme Menge an Daten erzeugen und für ein realistisches Testen auch Rausch- und Fehlverhalten simuliert werden müssen.

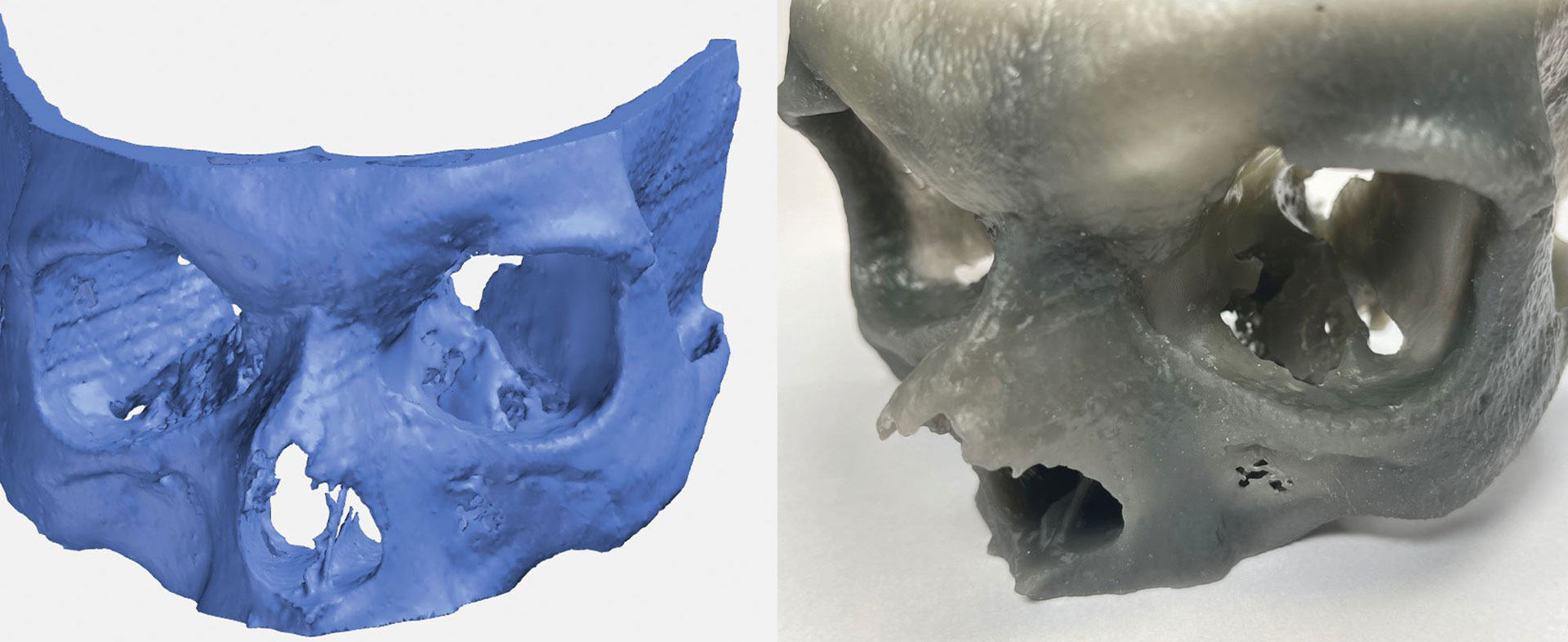

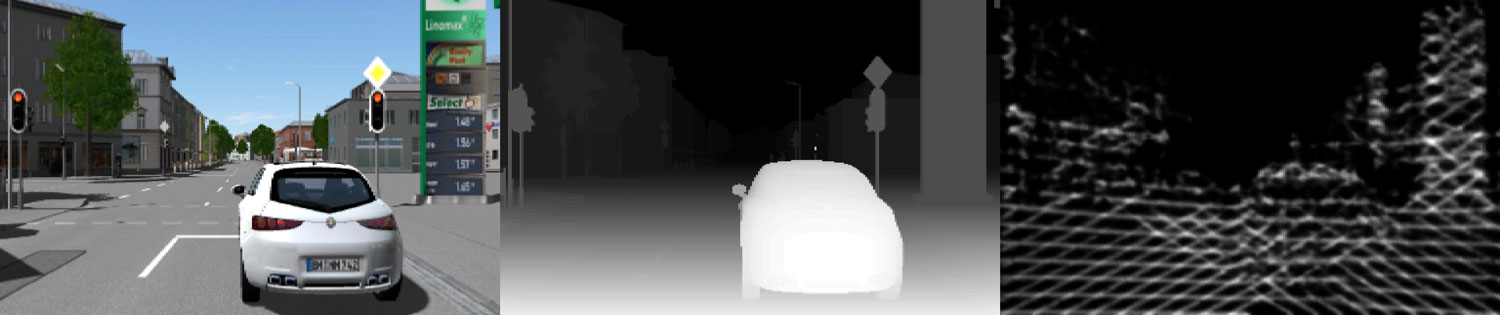

Ziel des Projektes war es, einen 3D-Umgebungssensor in einem virtuellen Fahrzeug in einer virtuellen Testumgebung realistisch zu simulieren. Dabei sollte vor allem die Ausgabe des Sensors in Form von Objektlisten realitätsnah sein – so können z. B. vorausfahrende Fahrzeuge nur erkannt werden, wenn ein signifikanter und für die Erkennung relevanter Teil des Fahrzeugs sichtbar ist. Eine solche realistische Simulation setzt voraus, dass man das Verhalten realer Sensoren am besten anhand von realen Messdaten erlernt und dann in die Simulation überträgt.

Grundlage des Projektes war ein großer Datensatz (Audi Autonomous Driving Dataset), in dem in Testfahrten die Ausgaben unterschiedlichster Sensoren in einem Fahrzeug, wie z. B. Kamerabilder und Lidar-Daten, erfasst wurden. Mit Verfahren des tiefen maschinellen Lernens wurde aus diesen Daten „gelernt“, aus Kamerabildern die Ausgabe eines Tiefensensors und die daraus resultierenden Objektlisten vorherzusagen. Diese Vorhersage wurde auf virtuelle Kamerabilder übertragen, sodass es in einer virtuellen Testumgebung möglich wird, das Verhalten eines Tiefensensors vorherzusagen und diesen virtuellen Sensor in der weiteren Test-Pipeline zu integrieren.